Создаём запрет на индексирование непонятных ссылок для сайта работающего на WordPress. Инструкция для сайта на ЧПУ формате. Добавляем директивы в файл robots.txt.

Правильный robots.txt для сайта очень важен. Если его нет или он настроен неверно, то Вордпресс нагенерирует очень много бессмысленных страниц. Особенно это касается сайтов переведенных на «дружественные ссылки» (friendly URL). Такие бессмысленные для поисковика страницы приводят к бану в поисковых системах. Например, Яндекс точно накладывает фильтр на такие сайты.

Если сайт на ЧПУ, то обязательно надо запретить все страницы в адресе которых знаки вопроса. Такие страницы генерируют, как некоторые установленные на сайт плагины, так и сам WordPress:

?format

page/10/?option=com_user&view=remind

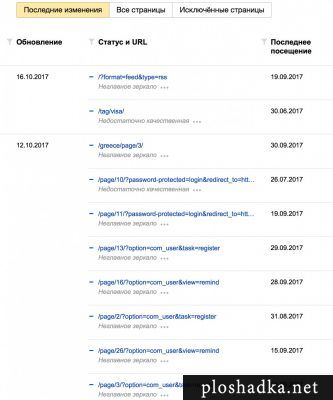

Страницы могут иметь и другие структуры, но объединяет их всех то, что в своём названии они содержат знаки вопроса. Подобные страницы часто дублируют основные страницы сайта. Откуда берутся такие ссылки непонятно. Например, на одном из своих сайтов я обнаружил в индексе Яндекса очень много таких страниц:

И хотя Яндекс старается исключать такие ссылки автоматически, лучше помочь ему это сделать на раннем этапе и не допускать попадание таких ссылок в индекс. Для этого в файл robots.txt добавим следующее:

Этим самым мы запрещаем все возможные URL вида со знаком вопроса. На сайтах работающих на ЧПУ ссылках все страницы со знаками вопроса — лишние. От таких ссылок можно и нужно избавляться.

Содержимое robots для WordPress

Ниже привожу свою базовую конфигурация для файла robots.txt для WordPress. Под базовой, я подразумеваю файлы, папки и структуры, которые находятся в WordPress с самого начала. Например, категории category или метки tag.

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /comment-subscriptions

Disallow: /tag/*/page/

Disallow: /category/*/page/

Disallow: /*/*/*/

Disallow: /date/

Disallow: /author/

Disallow: /*/feed/

Disallow: */comment

Disallow: /*.php

Disallow: /*?*

Sitemap: https://ploshadka.net/sitemapindex.xml

Host: https://ploshadka.net

Поясню ещё несколько моментов.

Эта директива запрещает индексировать все длинные структуры сайта:

Например, у меня на сайтах нет таких длинных адресов, однако кто-то может их использовать. Если таких адресов нет, то WordPress иногда сам их создаёт, тем самым создавая дубли страниц. Как раз для этого и нужна эта строчка. Т.е. такая страница будет проиндексирована:

А такая нет:

Следующие строчки запрещают индексировать все дополнительные страницы разделов и меток:

Disallow: /category/*/page/

Они не нужны, ведь индексация всех записей будет проходить через навигацию на главной странице.

Последнее на чем я хотел бы заострить внимание:

Disallow: /author/

Disallow: /*/feed/

Disallow: */comment

Disallow: /*.php

Запрещаем страницы авторов, архивы дат, дубли основных страниц (feed), отдельные страницы с комментариями и любые файлы c php.

Вот в этой статье dampi.ru/pravilnyiy-robots-txt-dlya-sayta-na-wordpress автор утверждает о том, что если открыть uploads для всех ботов, то в индексе появляются загруженные PDF и прочие текстовые файлы. А в яндекс вебмастере, в отчете «Исключенные страницы» появляются сообщения об ошибке при индексировании картинок, мол содержимое не поддерживается. Вот и не знаю кому верить…

В текущей статье нет ничего об uploads. С ним ничего делать не нужно.